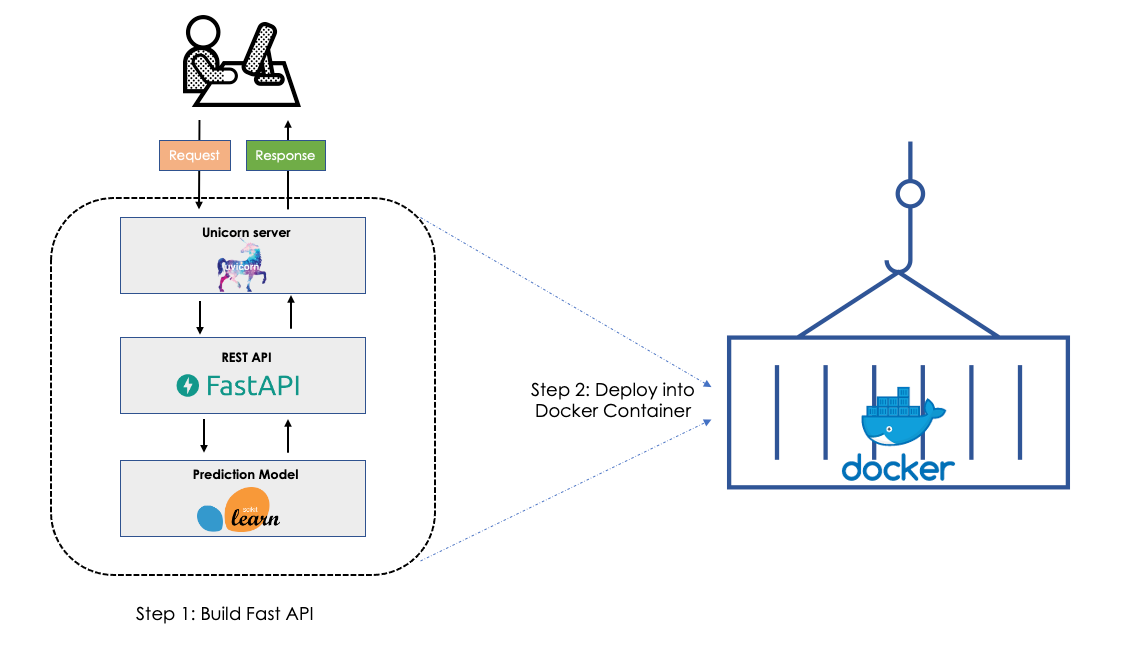

Deploy de modelos de machine learning é um dos principais desafios enfrentados por empresas que buscam tornar suas soluções de IA acessíveis em escala. Neste post, vamos abordar como você pode utilizar o FastAPI e o Docker para criar uma infraestrutura ágil, escalável e eficiente para colocar seus modelos de machine learning em produção.

1. Introdução

Com o crescimento do uso de inteligência artificial, muitas organizações enfrentam o problema de como disponibilizar seus modelos de machine learning de maneira eficiente. Sem um pipeline adequado, a entrega de modelos pode ser lenta, pouco confiável ou difícil de escalar. Neste cenário, FastAPI e Docker emergem como ferramentas poderosas que podem simplificar esse processo, permitindo um deploy rápido e seguro.

Segundo um estudo recente, 85% dos projetos de IA falham em chegar à fase de produção, frequentemente por causa de uma infraestrutura inadequada. Portanto, conhecer as ferramentas certas para o deploy é essencial para o sucesso de qualquer projeto de machine learning.

2. O Que é FastAPI e Por Que Utilizá-lo no Deploy?

FastAPI é um framework moderno, rápido e de alta performance para a criação de APIs em Python. Ele se destaca por seu desempenho, simplicidade e por ser baseado em tipagem assíncrona, o que permite melhor escalabilidade. Comparado com frameworks como Flask ou Django, o FastAPI pode lidar com mais requisições por segundo, além de fornecer validações automáticas.

Uma das grandes vantagens do FastAPI é sua compatibilidade com o padrão OpenAPI, que facilita a documentação automática de APIs, algo essencial em aplicações de machine learning que precisam ser expostas para outros sistemas ou usuários.

Ao utilizar o FastAPI, você pode transformar um modelo de machine learning em uma API robusta, pronta para produção, com apenas algumas linhas de código.

3. O que é Docker?

Docker é uma plataforma que permite desenvolver, testar e implantar aplicações de maneira eficiente e consistente, empacotando tudo o que a aplicação precisa para rodar (como código, bibliotecas, dependências e configurações) em um ambiente isolado chamado container. Isso garante que a aplicação possa ser executada em qualquer ambiente, desde o seu laptop até servidores na nuvem, sem que haja diferenças no comportamento do software.

O Problema Antes do Docker

Antes de Docker, desenvolver e implantar aplicações envolvia uma série de desafios relacionados a diferenças nos ambientes. Dependendo das configurações do sistema operacional, versões de bibliotecas, ou até mesmo do hardware, uma aplicação poderia rodar perfeitamente no ambiente de desenvolvimento e falhar em produção. Isso criava o famoso problema de “funciona na minha máquina”, dificultando a vida dos desenvolvedores e administradores de sistemas.

A Solução: Containers

Docker resolveu esse problema através de containers. Um container é uma unidade leve e portátil que inclui tudo o que a aplicação precisa para rodar. É como se fosse uma “mini-máquina virtual”, mas muito mais eficiente. Ele garante que a aplicação e suas dependências sejam isoladas do sistema operacional do host, criando um ambiente previsível, independentemente do local onde o container será executado.

O Docker utiliza a tecnologia de virtualização de contêineres, mas de forma diferente das máquinas virtuais tradicionais. Ao invés de virtualizar um sistema operacional inteiro, ele compartilha o kernel do sistema operacional do host, o que torna os containers extremamente rápidos e leves, usando menos recursos de CPU e memória.

Docker vs. Máquinas Virtuais

É importante entender a diferença entre containers e máquinas virtuais:

- Máquinas Virtuais (VMs): Uma máquina virtual inclui um sistema operacional completo, além da aplicação e suas dependências. Isso consome mais recursos (memória, CPU, armazenamento) e é mais lento de inicializar.

- Containers: Por outro lado, os containers compartilham o kernel do sistema operacional do host, sendo mais leves e rápidos. Eles utilizam apenas o que é necessário para rodar a aplicação, o que resulta em maior eficiência.

Como Funciona o Docker?

O Docker utiliza três principais componentes:

- Dockerfile: Um arquivo de texto com instruções para criar uma imagem. Ele define como o container será configurado, quais dependências precisam ser instaladas, qual comando será executado ao inicializar, entre outros detalhes.

- Imagem Docker: A imagem é um snapshot estático da aplicação e seu ambiente. Ela é criada a partir do Dockerfile e contém tudo o que o container precisa para rodar. Você pode pensar em uma imagem como um modelo para criar containers.

- Container: Um container é uma instância em execução de uma imagem. É no container que sua aplicação efetivamente roda. Como os containers são efêmeros, você pode criar, destruir e replicá-los facilmente conforme a necessidade.

Docker facilita o desenvolvimento e o deploy de aplicações, tornando o processo mais ágil e padronizado. Se você está criando APIs de machine learning, por exemplo, pode garantir que todas as dependências e versões necessárias para rodar o modelo estarão contidas no container, eliminando problemas de incompatibilidade ao mover a aplicação do seu ambiente local para um servidor de produção.

4. Exemplos Práticos e Casos de Uso: FastAPI

Vamos supor que você tenha um modelo de machine learning treinado para classificar imagens. Com o FastAPI, você pode rapidamente transformá-lo em um serviço acessível via API.

Aqui está um exemplo básico de como isso seria feito:

from fastapi import FastAPI

from pydantic import BaseModel

import pickle

app = FastAPI()

# Carrega o modelo treinado

with open("model.pkl", "rb") as f:

model = pickle.load(f)

class DataInput(BaseModel):

feature1: float

feature2: float

@app.post("/predict")

def predict(data: DataInput):

prediction = model.predict([[data.feature1, data.feature2]])

return {"prediction": prediction[0]}Na seção a seguir está um exemplo básico de um Dockerfile para sua aplicação FastAPI.

5. Como Utilizar Docker para Construir e Rodar sua API de Machine Learning

Para garantir que sua API de machine learning esteja pronta para produção e possa ser executada em diferentes ambientes sem problemas de configuração, utilizar o Docker é essencial. Docker permite criar um ambiente isolado e padronizado, garantindo que todos os requisitos e dependências estejam configurados corretamente.

Dockerfile: Configurando o Ambiente

Antes de rodar sua aplicação em um container, é necessário criar um Dockerfile, que define como a aplicação será montada e executada. O Dockerfile é essencial para empacotar sua API e suas dependências de maneira padronizada.

Aqui está um exemplo básico de um Dockerfile para uma API FastAPI:

# Usando uma imagem leve do Python

FROM python:3.12-slim

# Define o diretório de trabalho

WORKDIR /app

# Copia o arquivo de dependências

COPY requirements.txt .

# Instala as dependências necessárias

RUN pip install --no-cache-dir -r requirements.txt

# Copia o código da API para o container

COPY . .

# Expor a porta que o FastAPI irá rodar

EXPOSE 8000

# Comando para rodar a aplicação FastAPI

CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]Nesse exemplo, estamos utilizando a imagem base python:3.12-slim para garantir que nossa aplicação tenha uma imagem leve, contendo apenas o necessário para rodar a API FastAPI. O arquivo requirements.txt lista todas as dependências da aplicação, que serão instaladas no container.

Passo 1: docker build – Construindo a Imagem Docker

Com o Dockerfile configurado, o próximo passo é construir a imagem Docker. O comando docker build transforma o conteúdo do diretório onde está o Dockerfile em uma imagem Docker que pode ser usada para criar containers.

Execute o seguinte comando no terminal no diretório onde seu Dockerfile está localizado:

docker build -t minha-api-fastapi:latest .Neste comando:

docker buildé o comando que inicia a construção da imagem.-t minha-api-fastapi:latestdefine o nome da imagem e a tag (nesse caso,latest).- O

.no final refere-se ao diretório atual, que contém oDockerfile.

Após esse comando, a imagem Docker da sua API estará pronta para ser usada. A construção pode levar alguns minutos, especialmente na primeira vez, enquanto as dependências são instaladas e a imagem base é baixada.

Passo 2: docker run – Executando o Container

Com a imagem Docker construída, agora você pode rodar a aplicação em um container utilizando o comando docker run. Esse comando cria uma instância da imagem (um container) e a executa.

docker run -d -p 8000:8000 minha-api-fastapi:latestAqui, os parâmetros são:

-d: roda o container em modo “detached”, ou seja, em segundo plano.-p 8000:8000: mapeia a porta 8000 do container para a porta 8000 do seu host local. Isso permite que você acesse a API emhttp://localhost:8000.minha-api-fastapi:latest: especifica o nome e a tag da imagem que você quer rodar.

Agora, sua API FastAPI está rodando dentro de um container Docker, acessível localmente ou por qualquer cliente HTTP se estiver em produção. Se precisar parar o container, use o comando:

docker stop <container_id>Para visualizar os containers ativos e seus IDs, use:

docker psPasso 3: Integração Contínua com Docker

Uma prática recomendada para ambientes de produção é integrar o Docker com ferramentas de CI/CD (Integração Contínua e Entrega Contínua), como Jenkins, GitLab CI ou GitHub Actions. Isso permite que, a cada mudança no código da sua API, uma nova imagem seja construída e automaticamente implementada em produção.

Além disso, com o Docker, você pode facilmente escalar sua aplicação replicando containers e gerenciá-los com orquestradores como Kubernetes ou Docker Swarm.

Benefícios do Docker no Deploy de APIs

O uso de Docker no deploy de modelos de machine learning traz inúmeras vantagens, entre elas:

- Portabilidade: Com Docker, você pode rodar sua API em qualquer ambiente que suporte containers, seja no seu servidor local ou em plataformas de nuvem como AWS, Azure ou Google Cloud.

- Consistência: Docker garante que o ambiente de produção seja idêntico ao ambiente de desenvolvimento, eliminando problemas de dependências e configurações.

- Escalabilidade: Containers são leves e podem ser replicados facilmente, facilitando a escalabilidade horizontal da aplicação.

- Facilidade de Deploy: O processo de deploy é simplificado, permitindo que novos containers sejam lançados com apenas um comando.

6. Benefícios e Impacto: Por Que Utilizar FastAPI e Docker?

Aqui estão alguns dos benefícios de utilizar FastAPI e Docker no deploy de modelos de machine learning:

- Escalabilidade: FastAPI é altamente escalável, permitindo lidar com milhares de requisições simultâneas com mínima latência.

- Padronização: Dockerizar sua aplicação garante que o ambiente seja consistente, seja em desenvolvimento, teste ou produção.

- Facilidade de Integração: FastAPI se integra facilmente com outras ferramentas como Redis, PostgreSQL, e serviços na nuvem como AWS ou Azure.

- Manutenção Simplificada: A documentação automática do FastAPI facilita a manutenção e a expansão do projeto, especialmente em equipes grandes.

7. Como Consumir a API em Produção

Agora que você configurou sua API de machine learning com FastAPI e fez o deploy com Docker, é essencial saber como consumi-la em um ambiente de produção. Uma vez que sua API está rodando em um servidor (seja local ou em nuvem), você pode acessá-la de diferentes formas, seja através de um cliente HTTP como o Postman, um script Python ou até mesmo diretamente de uma aplicação web ou mobile.

Passo 1: Testando Localmente

Após rodar o Docker container em seu ambiente local, você pode acessar a API em http://localhost:8000. Para verificar se a API está funcionando corretamente, acesse o Swagger UI gerado automaticamente pelo FastAPI, navegando até:

http://localhost:8000/docsEssa interface permite testar seus endpoints diretamente pelo navegador e é extremamente útil durante o desenvolvimento.

Passo 2: Consumindo a API com uma Requisição HTTP

Uma vez que sua API está em produção, você pode consumi-la enviando requisições HTTP do seu cliente ou aplicação. Abaixo está um exemplo de como fazer uma requisição POST para o endpoint /predict da API utilizando Python e a biblioteca requests.

import requests

url = "http://api-seu-dominio.com/predict"

data = {

"feature1": 3.5,

"feature2": 1.2

}

response = requests.post(url, json=data)

# Verifica o status da requisição e imprime o resultado

if response.status_code == 200:

print(response.json())

else:

print(f"Erro: {response.status_code}")

Neste exemplo, estamos fazendo uma requisição para o endereço http://api-seu-dominio.com/predict, que seria a URL pública da sua API hospedada em um servidor de produção. Esse código envia um JSON com os dados necessários para que o modelo faça a predição e retorna a resposta da API.

Passo 3: Hospedagem da API em Produção

Para disponibilizar a API em produção, é comum utilizar plataformas de cloud computing, como AWS, Google Cloud ou Azure. Elas oferecem serviços para hospedar containers Docker, como AWS ECS, Google Cloud Run ou Azure Container Instances. Além disso, para escalar a aplicação, você pode configurar um balanceador de carga e até orquestrar múltiplos containers usando Kubernetes.

Uma vez hospedada, você terá uma URL pública para acessar sua API. É importante garantir que você configure adequadamente os recursos de segurança, como SSL/TLS para criptografar o tráfego e autenticação por tokens JWT ou OAuth para controlar quem pode acessar sua API.

Passo 4: Consumindo a API em um Frontend

Se você estiver desenvolvendo uma aplicação frontend, seja web ou mobile, pode consumir sua API diretamente, fazendo requisições HTTP com AJAX no JavaScript ou utilizando bibliotecas como Axios.

Aqui está um exemplo de como fazer uma requisição utilizando Axios em uma aplicação frontend:

import axios from 'axios';

const url = 'http://api-seu-dominio.com/predict';

const data = {

feature1: 3.5,

feature2: 1.2

};

axios.post(url, data)

.then(response => {

console.log(response.data);

})

.catch(error => {

console.error('Erro ao consumir API', error);

});

Ao integrar a API com o frontend, você consegue oferecer predições de machine learning em tempo real para seus usuários, transformando seus modelos em produtos interativos.

Considerações Finais para Consumo da API em Produção

- Escalabilidade: Ao configurar a API em produção, certifique-se de que o ambiente seja escalável, permitindo que a aplicação lide com picos de tráfego.

- Segurança: Proteja sua API com autenticação (OAuth, JWT) e criptografia de dados com HTTPS.

- Monitoramento: Utilize ferramentas de monitoramento, como Prometheus ou Datadog, para acompanhar o desempenho da API e garantir que ela esteja sempre disponível e funcionando conforme esperado.

- Documentação: O Swagger UI gerado automaticamente pelo FastAPI também pode ser utilizado em produção, ajudando desenvolvedores que consumirão sua API a entender melhor os endpoints e as entradas/saídas esperadas.

8. Desafios e Considerações ao Utilizar FastAPI e Docker

Embora FastAPI e Docker sejam ferramentas poderosas, é importante considerar os desafios e limitações ao usá-las.

- Gerenciamento de Estado: APIs em machine learning podem exigir que você gerencie estado, especialmente em modelos que precisam ser atualizados constantemente.

- Limitações de Recursos: O deploy de modelos complexos pode exigir grandes quantidades de CPU ou GPU, e otimizar o uso desses recursos pode ser desafiador, especialmente em ambientes Docker.

- Segurança: Garantir que sua API esteja segura é essencial, especialmente ao lidar com dados sensíveis. Certifique-se de configurar autenticação e autorização apropriadas.

9. O Futuro do Deploy

O futuro do deploy de modelos de machine learning tende a ser cada vez mais facilitado por ferramentas como FastAPI e Docker. Com o avanço da infraestrutura em nuvem, essas tecnologias permitem que empresas de todos os tamanhos adotem inteligência artificial sem se preocupar com a complexidade do deploy.

Tendências emergentes como serverless computing e orquestração de containers com ferramentas como Kubernetes estão rapidamente ganhando popularidade. Essas tecnologias combinadas permitem que o deploy de modelos se torne ainda mais simples e eficiente, com maior automação e menor dependência de infraestrutura física.

10. Conclusão

Neste artigo, exploramos como realizar o deploy de modelos de machine learning utilizando FastAPI e Docker, destacando a importância de uma boa infraestrutura de deploy para o sucesso de projetos de IA. Com a combinação dessas ferramentas, você pode facilmente transformar seus modelos em serviços escaláveis e prontos para produção.

Quer saber mais sobre como otimizar seus projetos de machine learning? Comente abaixo ou compartilhe este post para ajudar outros desenvolvedores a aprimorar suas habilidades!

11. Referências

Palavras-chave: Deploy de modelos de machine learning, FastAPI, Docker, machine learning em produção, Docker build, Docker run, deploy de IA, escalabilidade, consumo de API